ROCm 7: Qué trae, Por qué importa y Cómo te cambia la vida

Si trabajas con IA, HPC o aceleradores en Linux (y ahora también Windows), seguro has oído hablar de ROCm, la plataforma abierta de AMD para programar sus GPUs. ROCm 7 acaba de llegar y trae mejoras importantes. Es hasta 3,5× más rápido en inferencia y 3× en entrenamiento, gracias al soporte de tipos de datos reducidos como FP4/FP6 y mejores pilas de comunicación.

Usando NVIDIA y CUDA, sabes que tienes rendimiento, pero también una dependencia enorme de un único fabricante. AMD lleva años intentando plantar cara con su plataforma ROCm (Radeon Open Compute), y la verdad es que con ROCm 7 las cosas se han puesto serias.

No hablamos de una actualización menor. Hablamos de una mejora que está sacando músculo en entornos de entrenamiento de modelos grandes, con soporte para más tipos de datos (como FP4 y FP6, sí, estamos bajando de precisión para ganar velocidad), mayor compatibilidad (Ejemplo: Windows) y un entorno más maduro. Todo esto sin pagar licencias, sin firmar acuerdos cerrados y, por fin, con una experiencia de desarrollo que no te hace sentir en beta perpetua.

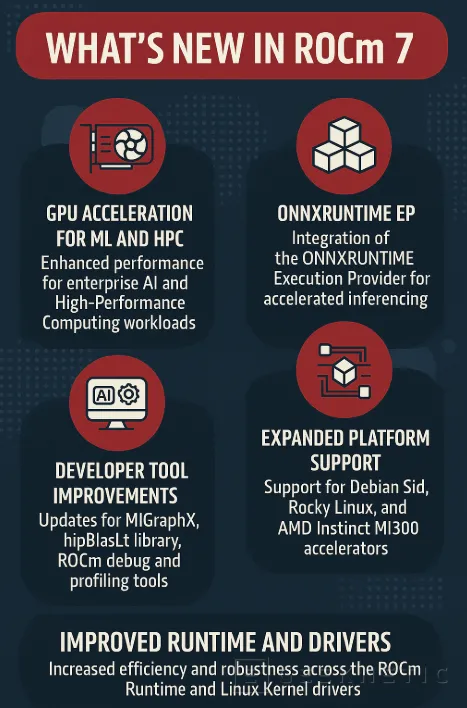

¿Qué trae ROCm 7 a nivel técnico que importe?

- Tipos de datos nuevos para IA rápida

ROCm 7 ahora soporta FP4 y FP6, que son formatos de punto flotante de 4 y 6 bits. ¿Por qué es importante? Porque los modelos de lenguaje e IA generativa no siempre necesitan la precisión de FP32 o FP16. Estos nuevos tipos permiten:

- Más datos en menos memoria

- Más rendimiento en inferencia sin penalizar calidad

- Mejoras en la comunicación GPU-GPU

Gracias a la integración con RCCL (el “NCCL” de AMD), ahora se gestiona mucho mejor el tráfico entre GPUs. Esto permite escalar modelos de forma distribuida sin ahogarte en latencia.

- Compatibilidad más allá de Linux

Sí, por fin ROCm se está probando también en Windows (aún limitado, pero va en camino), y soporta una gama más amplia de hardware AMD, desde Instinct MI300X hasta tarjetas Radeon y Ryzen AI. Esto abre el juego a desarrolladores y data scientists con estaciones de trabajo personales.

- Herramientas que acompañan

Han mejorado:

- El instalador

- Soporte en Kubernetes vía GPU Operator

- Compatibilidad con PyTorch, TensorFlow y entornos tipo vLLM

¿Qué cambia respecto a CUDA?

A continuación, os dejamos una pequeña comparativa entre CUDA/NVIDIA y ROCm/AMD:

|

Elemento |

CUDA/NVIDIA |

ROCm/AMD |

|---|---|---|

|

Licencia |

Propietaria |

Abierta (MIT, BSD, GPL) |

|

Frameworks soportados |

PyTorch, TensorFlow, cuDNN, JAX… |

PyTorch, TensorFlow, ONNX, JAX (en beta) |

|

GPUs soportadas |

Solo NVIDIA |

Instinct, Radeon, Ryzen AI |

|

Soporte multi-GPU |

Excelente (NCCL) |

Mejorando (RCCL), bueno en ROCm 7 |

|

Experiencia Windows |

Completa |

En desarrollo |

|

Ecosistema |

Maduro, sólido |

Creciendo fuerte |

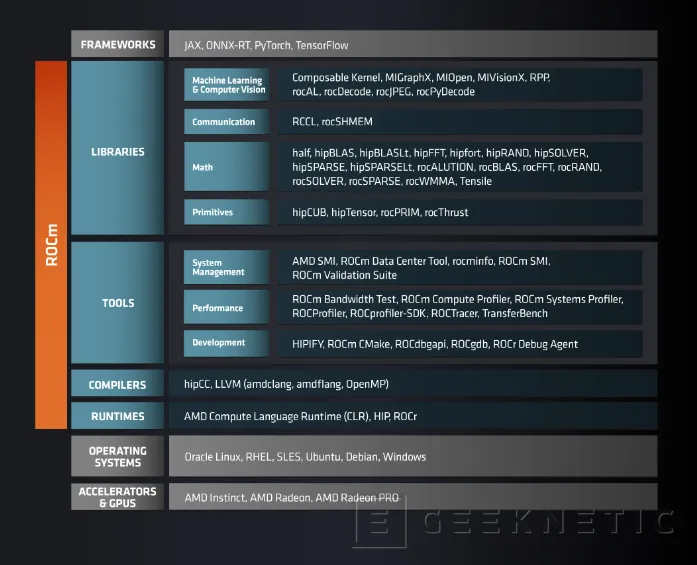

Componentes más importantes de ROCm 7

ROCm (Radeon Open Compute) es un stack completo para desarrollo y ejecución de aplicaciones en GPUs AMD, especialmente para IA, HPC y cargas paralelas. En su versión 7, estos son los componentes principales:

|

Componente |

¿Qué hace? |

|

HIP (Heterogeneous-Compute Interface for Portability) |

Capa de abstracción de CUDA. Permite portar código CUDA a ROCm. |

|

ROCr Runtime |

Runtime de ejecución de bajo nivel. Coordina la interacción con la GPU. |

|

ROCm Compiler (LLVM) |

Usa LLVM para compilar kernels. Compatible con C++, HIP y más. |

|

MIOpen |

Librería de primitivas de aprendizaje profundo (como cuDNN en NVIDIA). |

|

rocBLAS |

BLAS optimizado para GPUs AMD. Operaciones vectoriales y matrices. |

|

rocFFT / rocRAND / rocSPARSE |

Librerías de álgebra y estadísticas. Para ciencia de datos y ML. |

|

RCCL (AMD NCCL) |

Comunicaciones GPU-GPU de alto rendimiento (usado para entrenamiento distribuido). |

|

ROCm SMI & Profilers |

Monitorización de hardware, métricas, temperatura, uso de VRAM. |

|

PyTorch / TensorFlow (compatibles) |

Backends optimizados para frameworks de IA populares. |

¿Cómo se implementa ROCm 7?

Estación de trabajo personal (Linux)

- Requisitos previos:

- GPU compatible: AMD Radeon RX 6000/7000, Instinct MI200/MI300, algunas Ryzen con GPU integrada.

- Distribución recomendada: Ubuntu 20.04 o 22.04 LTS.

- Instalación:

- Añadir los repositorios:

- sudo apt update && sudo apt install wget gnupg2

- wget https://repo.radeon.com/rocm/rocm.gpg.key

- sudo gpg --dearmor -o /etc/apt/keyrings/rocm.gpg < rocm.gpg.key

- echo 'deb [signed-by=/etc/apt/keyrings/rocm.gpg] https://repo.radeon.com/rocm/apt/debian/ ubuntu main' | sudo tee /etc/apt/sources.list.d/rocm.list

- Instalar ROCm:

- sudo apt update

- sudo apt install rocm-dev

- Añadir los repositorios:

- Verificar:

- Ver GPU con rocminfo o rocm-smi.

Compilar código HIP o ejecutar un modelo PyTorch con backend AMD.

ROCm 7 como alternativa a CUDA

Al no tener que pagar licencias, ROCm permite montar clústeres IA más económicos, especialmente si combinas Open Source + hardware AMD, algo que puede ser muy interesante para Entornos académicos o Pymes.

ROCm 7 no es para todo el mundo. Si trabajas con herramientas cerradas o software exclusivamente basado en CUDA, todavía vas a encontrar límites. Pero si eres desarrollador de IA, científico de datos o montas infraestructuras HPC, ROCm 7 te da libertad, potencia y madurez. Y eso, en un mundo donde todo viene con condiciones y licencias, vale mucho más que unos frames por segundo.

Si estás empezando con AMD, testea tus modelos pequeños. Si ya usas PyTorch o TensorFlow, empieza a portar. Y si estás montando clúster, ROCm 7 ya está preparado para producción real. Con el soporte actual, el ahorro económico y la comunidad creciendo, no te quedes fuera del cambio.

Fin del Artículo. ¡Cuéntanos algo en los Comentarios!