IBM y AMD se alían para impulsar la supercomputación cuántica con integración de CPU, GPU, FPGA y ordenadores tolerantes a fallos

por Manuel NaranjoCuando dos actores tan distintos se sientan a la misma mesa es porque ven venir el mismo futuro. IBM y AMD han hecho público que trabajarán juntos en arquitecturas que mezclan computación cuántica y alto rendimiento clásico. No es una alianza para salir del paso, sino un intento serio de convertir en rutina algo que, hasta ahora, vivía en laboratorios y demostraciones: que un problema real se trocee y que cada trozo lo resuelva el motor que mejor encaja, ya sea un cúbit o una GPU.

La idea tiene sentido práctico. La parte cuántica sirve para lo que el silicio tradicional lleva décadas esquivando (simulaciones a nivel atómico, optimizaciones gigantescas, búsqueda en espacios combinatorios imposibles). La parte clásica (CPU, GPU, FPGA y aceleradores de IA) se queda con todo lo que exige ancho de banda, memoria y escala: ingestión de datos masiva, entrenamiento o postprocesado. En ese “toma y daca” está la gracia del enfoque híbrido.

Bits y cúbits, cada uno en su sitio

La diferencia entre ambos mundos no es de marketing. En el clásico, los bits valen 0 o 1; en el cuántico, los cúbits pueden representar superposiciones y entrelazarse. Ese truco físico abre puertas a atajos matemáticos que no existen en lo clásico. Pero la realidad también pone límites: con los cúbits los errores aparecen y hay que corregirlos; el ciclo de trabajo sigue siendo frágil. Por eso esta alianza no vende el cuento de reemplazar nada, sino de coordinar lo que ya funciona con lo que empieza a despegar.

Qué pone cada uno encima de la mesa

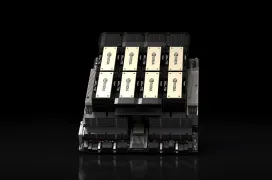

IBM llega con el músculo cuántico (hardware y software) y un ecosistema abierto que ya suena familiar: Qiskit para programar, IBM Quantum System Two como plataforma modular y una hoja de ruta que mira a ordenadores tolerantes a fallos antes de que termine la década. No es teoría: la compañía ya ha mostrado integración directa con Fugaku (RIKEN, Japón), uno de los supercomputadores clásicos más rápidos, y colabora con actores tan dispares como Cleveland Clinic, el Gobierno Vasco o Lockheed Martin para buscar casos de uso donde el híbrido aporte algo medible.

AMD trae experiencia de campo en la otra mitad de la ecuación. Sus CPU EPYC y sus GPU Instinct mueven Frontier (Oak Ridge), primer sistema exaescala certificado, y El Capitan (Lawrence Livermore), ambos en lo más alto del ranking TOP500. Además de potencia, aporta FPGA y una pila de software abierta que ya usan los grandes proveedores de nube para IA generativa. Dicho en corto: saben construir y operar la parte clásica a escala y con plazos.

La demostración que marcará el tono

El plan inmediato pasa por una prueba conjunta este mismo año. La idea es enseñar un flujo de trabajo completo donde un ordenador cuántico de IBM se coordina con CPU, GPU y FPGA de AMD para ejecutar un pipeline híbrido. No es solo “llamar a un kernel cuántico y volver”: hablamos de orquestar colas de trabajo, gestionar latencia entre mundos muy distintos y, sobre todo, corregir errores en tiempo real. Aquí AMD puede jugar un papel interesante: parte de la tolerancia a fallos cuántica necesita apoyo clásico rápido y predecible.

El papel del código abierto

No es casual que se insista en plataformas abiertas. Si los algoritmos híbridos se quedan encerrados en un SDK propietario, la adopción será lenta. Con Qiskit como base y las pilas de AMD expuestas de forma estándar, investigadores y empresas pueden funcionar sin empezar de cero cada vez que hay un cambio de hardware. Esto importa tanto como las cifras de rendimiento: reduce fricción y permite que los avances viajen de un laboratorio a un entorno productivo sin perderse por el camino.

Por qué esto importa más allá de la teoría

Bajado a tierra, lo interesante está en cómo se reparten las tareas. Un pipeline de descubrimiento de fármacos puede delegar en la parte cuántica la simulación fina de moléculas y enlaces, mientras la parte clásica filtra bibliotecas gigantes, entrena modelos y valida resultados a un ritmo que una única máquina cuántica no podría asumir.

En materiales, los cúbits explorarían configuraciones que hoy son prohibitivas; la supercomputación clásica validaría, escala en mano, los mejores candidatos. En logística, la formulación del problema se resolvería con estrategias cuánticas mientras el sistema tradicional ingiere y actualiza datos del mundo real en tiempo casi real. No se trata de promesas vagas, sino de dividir y vencer.

Obstáculos que nadie esconde

Queda trabajo por delante y conviene decirlo sin rodeos. En los cúbits exigen códigos de corrección costosos; orquestar un flujo híbrido introduce latencias que hay que controlar; los centros de datos no están pensados (todavía) para convivir con criogénia a gran escala. También hay una cuestión de costes: la parte clásica ya es cara; añadir la cuántica sin un retorno claro sería un lujo. La buena noticia es que la alianza aborda justo estas piezas: integración, corrección y estandarización.

La moraleja es sencilla: el futuro de la informática no será “cuántico” o “clásico”, será mixto. Y quien logre que ambas mitades se hablen sin fricción tendrá ventaja. La alianza entre IBM y AMD va justo de eso: menos PowerPoint, más tuberías reales entre dos mundos que, por fin, empiezan a encajar.

Fin del Artículo. ¡Cuéntanos algo en los Comentarios!