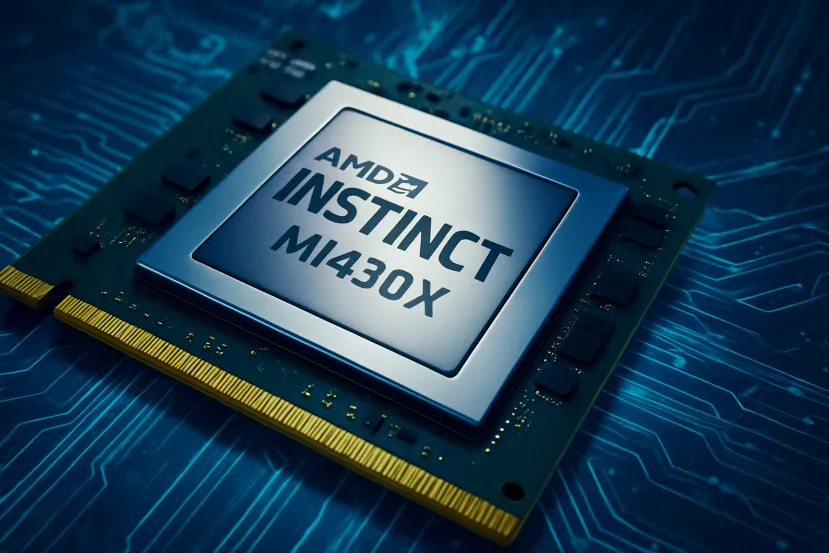

AMD presenta la Instinct MI430X con HBM4 y hasta 432 GB para impulsar la próxima generación de IA y supercomputación

por Manuel Naranjo 2La carrera de la inteligencia artificial lleva meses dejando una sensación clara: los modelos crecen más rápido que la infraestructura que los sostiene. Entrenar un gran modelo hoy no va solo de poner más GPUs sobre la mesa, sino de resolver cuellos de botella cada vez más serios en memoria, consumo y escalabilidad.

En ese contexto, AMD ha presentado la Instinct MI430X como su aceleradora para la siguiente ola de IA y computación científica, con una propuesta que no se queda en “más potencia”, sino en cambiar dónde está el límite.

Unas cifras pensadas para modelos gigantes

Lo primero que llama la atención de la MI430X es el enfoque brutal en memoria. AMD habla de hasta 432 GB de HBM4 por GPU y un ancho de banda de 19,6 TB/s. Esto es una declaración de intenciones: en IA moderna la memoria manda. No solo por capacidad total, sino porque el tráfico de datos es el que define la velocidad real cuando entrenas o haces inferencia con modelos enormes. Si la GPU se queda esperando a que llegue el dato, da igual lo rápida que sea en cálculo.

HBM4 no es un detalle menor. Es la nueva generación de memoria de alto ancho de banda, la que se está convirtiendo en el sustrato de los aceleradores de IA más avanzados. Más capacidad y más velocidad significa menos particionado del modelo, menos trucos para “encajarlo” y más eficiencia cuando escalas a cientos o miles de GPUs.

La idea clave: IA y HPC ya son el mismo problema

AMD insiste en algo que en la práctica ya está pasando en supercomputación: la frontera entre HPC clásico y entrenamiento de IA se está difuminando. La MI430X está diseñada para esa convergencia, soportando precisiones típicas de IA (FP4 y FP8), pero también FP64 real a nivel de hardware, que es lo que exige la simulación científica seria.

Esto importa porque los centros de investigación no quieren dos máquinas distintas: una para simulaciones y otra para IA. Quieren una sola plataforma capaz de alternar cargas sin perder rendimiento ni precisión. La apuesta de AMD es que su MI400 Series (donde entra la MI430X) sea ese motor híbrido que permite usar el mismo “suelo” computacional para generar datos con simulación y luego entrenar modelos que los interpreten.

De MI250X a MI430X, tres escalones de evolución

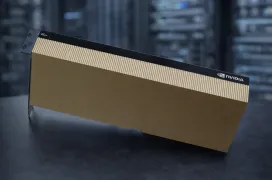

La MI430X no aparece de la nada. AMD la coloca como el tercer gran salto en su línea Instinct orientada a supercomputación. Primero llegó la MI250X, que puso las bases de Frontier con un diseño dual y una integración muy estrecha con CPU vía Infinity Fabric. Luego la MI300A, la APU de centro de datos que mezcla CPU y GPU en un paquete único y que es el corazón de El Capitan. Y ahora la MI430X, que recupera la idea de GPU pura, pero con un músculo de memoria y precisión pensado tanto para IA masiva como para ciencia.

Otro punto interesante es dónde van a acabar estas GPUs. AMD ha anunciado que la MI430X será la base de Discovery, un supercomputador en Oak Ridge pensado como “fábrica de IA” para el ecosistema científico estadounidense, junto a EPYC Venice y la plataforma HPE Cray. El mensaje aquí es político y técnico a la vez: soberanía de datos y capacidad doméstica para entrenar modelos críticos.

En Europa ocurre algo parecido con Alice Recoque, un sistema exascale anunciado por GENCI/CEA y Eviden que combinará MI430X con EPYC Venice para cargas de doble precisión y grandes modelos.

ROCm y el terreno del software, donde se decide todo

En hardware, los números impresionan, pero la historia reciente deja claro que sin software no hay victoria. AMD apoya la MI430X en ROCm, su plataforma abierta para IA y HPC, y recalca compatibilidad con frameworks clave como PyTorch, TensorFlow o JAX.

Aquí el reto es doble. Por un lado, competir con ecosistemas que llevan años de ventaja en herramientas, librerías y hábitos de desarrollo. Por otro, conseguir que añadir miles de GPUs AMD no suponga reescribir medio pipeline. ROCm ha avanzado mucho en los últimos años, pero el campo de batalla real es el rendimiento estable a escala, y eso solo se prueba cuando llegan instalaciones como Discovery o Alice Recoque.

La MI430X apunta a un escenario muy concreto: modelos multimodales gigantes entrenados en clústeres colosales y simulación científica que ya incorpora IA en el flujo de trabajo. Si las especificaciones se traducen en rendimiento real, AMD gana algo importante: una alternativa sólida para centros que no quieren depender de un único proveedor y que buscan eficiencia energética por vatio en vez de solo potencia bruta.

En resumidas cuentas, la MI430X no es solo otra GPU más rápida. Es la pieza con la que AMD intenta mover el cuello de botella hacia delante: más memoria, más ancho de banda y una arquitectura preparada para que IA y ciencia se ejecuten en el mismo carril. Si esa promesa se cumple en los supercomputadores que ya la tienen reservada, 2026 puede ser el año en que AMD se siente en la mesa principal de la IA a gran escala sin pedir permiso.

Fin del Artículo. ¡Cuéntanos algo en los Comentarios!