Microsoft estrena el clúster NDv6 GB300 con más de 4.600 GPU NVIDIA Blackwell Ultra: la nueva supercomputadora de Azure para impulsar la IA de OpenAI

por Manuel NaranjoEn un sector donde cada generación de hardware parece durar menos que una moda tecnológica, Microsoft ha vuelto a mover ficha. La compañía de Redmond ha presentado la nueva serie de máquinas virtuales NDv6 GB300, impulsada por un coloso de ingeniería: un clúster de producción a escala industrial con sistemas NVIDIA GB300 NVL72, diseñado para las cargas de trabajo de inferencia de IA más exigentes.

Detrás de este anuncio hay más que especificaciones técnicas. Hay una declaración de intenciones: Azure no quiere ser solo una nube para ejecutar inteligencia artificial, sino la infraestructura donde se define el futuro de la IA.

Un salto de escala que redefine lo que significa “nube”

El nuevo clúster NDv6 GB300 es, en la práctica, una supercomputadora distribuida capaz de procesar modelos que antes requerían infraestructuras separadas o dedicadas. Con más de 4.600 GPU NVIDIA Blackwell Ultra conectadas mediante la red NVIDIA Quantum-X800 InfiniBand, el sistema lleva el concepto de “hiperescala” a un terreno que, hasta hace poco, solo ocupaban laboratorios gubernamentales o centros de investigación.

La propia Nidhi Chappell, vicepresidenta corporativa de Infraestructura de IA en Azure, lo resumía con una frase calculada: “No se trata solo de potencia bruta; se trata de optimizar cada capa del centro de datos moderno para la IA.”

Esa frase encierra la clave de lo que Microsoft ha conseguido: repensar el hardware, la memoria, la red y la refrigeración como un único organismo.

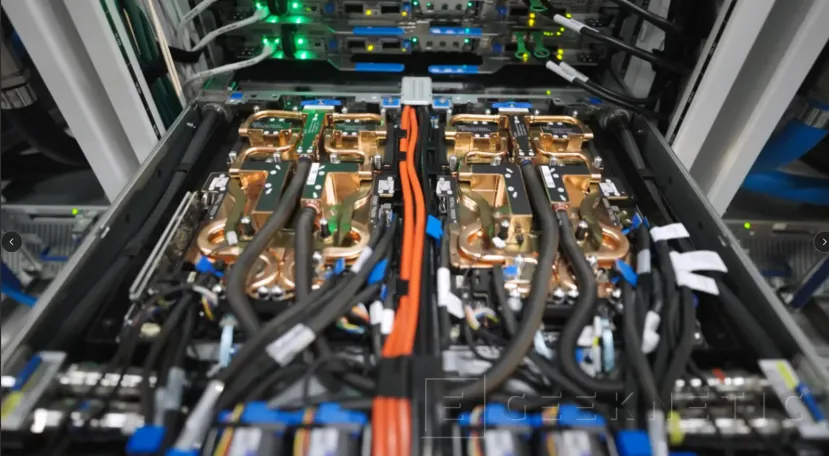

Dentro del motor: 72 GPU por rack, refrigeración líquida y memoria descomunal

El corazón de cada máquina virtual NDv6 GB300 es el sistema NVIDIA GB300 NVL72, una unidad a escala de rack con refrigeración líquida y una densidad que asusta. Cada módulo integra 72 GPU Blackwell Ultra y 36 CPU Grace, todas interconectadas mediante NVLink Switch de quinta generación.

El resultado es una máquina virtual con 37 TB de memoria rápida y 1,44 exaflops de rendimiento FP4 Tensor Core, una cifra que hace apenas tres años habría parecido ciencia ficción. Ese espacio de memoria unificado es lo que permite entrenar y ejecutar modelos de razonamiento e inteligencia artificial multimodal (los mismos en los que trabaja OpenAI, socio principal de Azure) sin que la latencia o la fragmentación de datos frenen el proceso.

Blackwell Ultra, la joya de NVIDIA para 2025, no solo se ha diseñado para fuerza bruta. Su arquitectura incorpora formatos de precisión NVFP4, que reducen consumo y duplican rendimiento frente a generaciones anteriores, además de NVIDIA Dynamo, una tecnología que optimiza la inferencia dinámica en modelos de razonamiento.

En los últimos benchmarks MLPerf Inference v5.1, esta combinación logró un rendimiento hasta cinco veces superior al de la arquitectura Hopper, estableciendo nuevos récords en modelos como DeepSeek-R1 (671 B de parámetros) o Llama 3.1 405B.

Una red a la altura del reto: NVLink y Quantum-X800

Toda esta potencia sería inútil sin una red capaz de mover los datos a la misma velocidad. Microsoft y NVIDIA han diseñado una arquitectura de interconexión de dos niveles: vertical, dentro de cada rack, y horizontal, entre racks.

En el interior, el sistema NVLink Switch ofrece 130 TB/s de ancho de banda directo entre las 72 GPU de un rack, de modo que actúan como un solo acelerador con memoria compartida. En el exterior, la red Quantum-X800 InfiniBand conecta los más de 4.600 chips con 800 GB/s por GPU, apoyada en conmutadores Quantum-X800 y tarjetas ConnectX-8 SuperNIC.

Esta combinación permite que un modelo de IA de miles de millones de parámetros funcione como si se entrenara en una sola máquina gigantesca. Además, la red utiliza telemetría activa y control adaptativo de congestión, junto con el protocolo SHARP v4 de NVIDIA, que reduce operaciones de reducción y agrega datos directamente en el hardware, multiplicando la eficiencia en entrenamiento e inferencia.

Una colaboración de años entre gigantes

El anuncio de Azure no ha surgido de la nada. Microsoft y NVIDIA llevan varios años trabajando en tándem para construir la infraestructura que sustenta los avances de OpenAI y otras compañías que entrenan modelos de nueva generación.

Este clúster NDv6 GB300 es el resultado de esa colaboración, pero también una inversión estratégica de país: refuerza la posición de Estados Unidos como epicentro del desarrollo de IA avanzada y reduce la dependencia de infraestructuras ajenas.

Según fuentes cercanas al proyecto, la construcción de este sistema requirió revisar cada capa del centro de datos de Azure, desde el diseño de la refrigeración líquida y la distribución eléctrica, hasta una nueva pila de software de orquestación y almacenamiento adaptada a la escala de los modelos actuales.

Lo que viene: la nube como superordenador global

El objetivo de Microsoft no es solo ofrecer un nuevo tipo de máquina virtual, sino convertir Azure en una red de supercomputadoras modulares capaces de crecer sin límites. El NDv6 GB300 es el primer bloque visible de ese plan.

A medida que la compañía amplíe su parque hasta cientos de miles de GPU Blackwell Ultra, el impacto será doble: ofrecerá a clientes como OpenAI una plataforma de rendimiento sin precedentes y, al mismo tiempo, democratizará el acceso a recursos de computación extrema para startups, universidades y desarrolladores.

Con este lanzamiento, Microsoft no solo levanta la infraestructura que moverá la próxima ola de modelos de IA. Está dibujando el esqueleto del futuro digital: una nube que ya no es un servicio remoto, sino un superordenador global compartido.

Fin del Artículo. ¡Cuéntanos algo en los Comentarios!