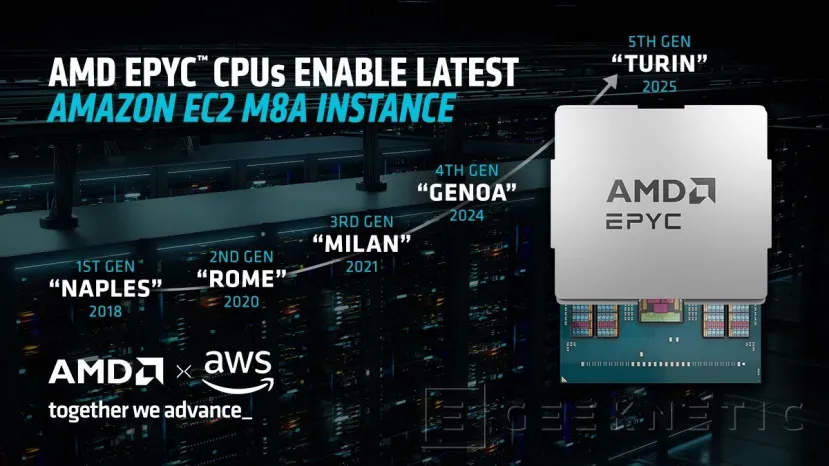

AWS presenta las nuevas instancias EC2 M8a con procesadores AMD EPYC de 5.ª generación y un rendimiento hasta un 30 % superior

por Manuel NaranjoHay lanzamientos que no solo suman catálogo, sino que mueven el listón de lo que consideramos “equilibrio” en la nube. Las Amazon EC2 M8a, basadas en AMD EPYC de 5.ª generación, pertenecen a esa categoría: no persiguen el récord en un único vector, sino que combinan cómputo, memoria y red con un salto que se traduce en más trabajo hecho por hora y menos sorpresas al escalar.

AWS lleva desde 2018 incorporando cada iteración de EPYC; la M8a es la evolución natural de esa apuesta, con hasta un 30 % más de rendimiento frente a la generación previa y novedades que importan en cargas reales.

El valor técnico detrás del “30 % más”

El dato de rendimiento por sí solo es un titular. Lo interesante es de dónde sale: a la mejora de IPC de la arquitectura se suman más ancho de banda de memoria, más techo de red y almacenamiento y la llegada de AVX-512 al plano generalista. Esa combinación reduce cuellos de botella típicos (memoria que se queda corta cuando sube la CPU, E/S que no acompaña) y habilita optimizaciones vectoriales en codificación, personalización y ML sin cambiar de familia de instancia.

Dónde encaja mejor (y por qué)

La M8a está pensada para el día a día serio: hosting web y de aplicaciones, microservicios que crecen horizontalmente, bases de datos que piden latencia baja y previsibilidad, entornos de desarrollo/QA donde la mezcla de CPU, RAM y red cambia por sprint.

También absorbe bien cargas con picos, porque la relación núcleo/memoria y la red disponible evitan que el sistema se “atragante” al primer burst. No es la opción para HPC extremo ni para memoria descomunal; es la “liga mayor” del propósito general.

AVX-512 sin dolor: cuándo se nota

La llegada de AVX-512 a esta familia permite acelerar bloques muy concretos: transcodificación, vectorización en librerías de ML, analítica con kernels que ya soportan instrucciones anchas. La clave es comprobar si tus builds ya vienen con flags adecuados o si dependes de binarios genéricos. Si tu stack es containerizado, bastará con una imagen optimizada; si no, puedes obtener mejoras “gratis” gracias a bibliotecas que detectan capacidades en tiempo de ejecución.

Escalar con cabeza: coste, densidad y previsibilidad

El equilibrio de la M8a ayuda a afinar el TCO de equipos que no encajan del todo en C (cómputo puro) ni en R (memoria). Menos overprovisioning, menos instancias ociosas: más fácil atinar con el tamaño y reducir el coste por transacción. Si vienes de M7a, el salto de rendimiento y de I/O permite consolidar (migrar N instancias a N–x) manteniendo SLOs. Con Savings Plans o Reservas a medio plazo, la ecuación económica suele mejorar sin reescribir nada.

Migración práctica desde M6a/M7a

No hay ciencia oculta: misma ISA x86-64, misma capa de servicios AWS. Buenas prácticas mínimas:

- Recompilar donde tenga sentido (bibliotecas con rutas AVX-512) y validar fallbacks.

- Revisar memoria por vCPU y headroom de red para no conservar tamaños por pura inercia.

- Test A/B con tráfico real (o shadow traffic) antes de consolidar.

- Observar EBS/ENI: si el límite de IOPS/GB o de throughput cambiaba tu perfil, ajústalo.

¿Y frente a Graviton?

Graviton brilla en eficiencia por vatio y coste en servicios elásticos escritos en lenguajes modernos. La M8a compensa con compatibilidad inmediata (ecosistema x86 inmenso), AVX-512 y una curva de adopción sin fricciones para stacks con componentes cerrados o librerías x86 específicas. No es un “o lo uno o lo otro”: muchas arquitecturas combinan Graviton para fronts/microservicios y M8a para backends que dependen de optimizaciones x86 o de herramientas que rinden mejor con vectorización ancha.

Qué medir antes de mover producción

Más allá del bench, lo que decide es el perfil de tu aplicación:

- CPU sostenida vs. latencia por petición.

- Ancho de banda de memoria: ¿te limita el GC, la analítica en memoria o joins pesados?

- Red y almacenamiento: ¿tira de gRPC/Kafka y EBS intensivo o trabaja “en local”?

- Picos: ¿necesitas headroom para eventos en vivo o promociones?

Si esos vectores están en equilibrio, la M8a encaja; si uno domina (memoria, cómputo puro, GPU), conviene mirar familias específicas.

Señales del mercado: adopción con nombre y apellidos

Que plataformas como Netflix destaquen EPYC de 5.ª generación para eventos en vivo no es casual: ahí performance y escalabilidad se miden al segundo. La M8a añade justo lo que ese tipo de cargas agradecen (vectorización, I/O, previsibilidad), pero sin obligar a saltar a instancias especializadas. Es un piso sólido para crecer.

La EC2 M8a no pretende deslumbrar con un récord aislado; busca que todo esté a la altura a la vez: CPU, memoria, red y tooling.

Fin del Artículo. ¡Cuéntanos algo en los Comentarios!