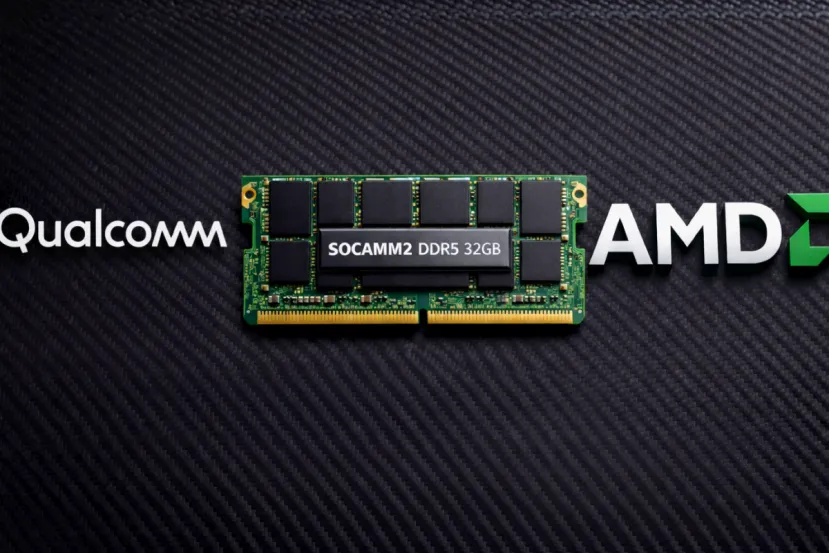

Qualcomm y AMD ponen el ojo en SOCAMM2: la memoria modular de bajo consumo que puede redefinir la IA en servidores

por Manuel NaranjoEn los centros de datos se habla de chips como si fueran cromos, pero muchas decisiones se toman por algo menos vistoso: la memoria. No solo cuánta hay, sino cómo se integra, cuánto calienta y qué margen deja para escalar una plataforma sin rediseñarla desde cero. Con la IA generativa empujando, la carrera ya no va solo de computar. Va de alimentar a los aceleradores con datos sin que el consumo y la refrigeración se disparen.

Ahí es donde entra SOCAMM2, un formato de memoria basado en LPDDR5 y LPDDR5X pensado para sistemas de IA en centros de datos. La novedad es que el interés se estaría ampliando: Qualcomm y AMD estarían explorando su adopción para productos de IA.

Qué es SOCAMM2 y por qué importa

SOCAMM2 significa Small Outline Compression Attached Memory Module. En la práctica, es un módulo compacto que se fija con un conector de compresión y permite montar memoria LPDDR en un formato reemplazable, sin soldadura permanente. La promesa es simple: aprovechar la eficiencia de LPDDR, pero con modularidad y mantenimiento de entorno servidor.

La razón de fondo es energética. LPDDR nació para móviles y portátiles, donde cada vatio cuenta. En IA, esa lógica se vuelve oro: cuando un clúster se pasa horas a plena carga, cualquier mejora de eficiencia se multiplica en coste eléctrico y en densidad por rack.

JEDEC lo convierte en apuesta segura

Para que un formato así no se quede en una rareza, necesita un marco común. JEDEC anunció la fase final de JESD328, el estándar SOCAMM2 para módulos LPDDR5 y LPDDR5X orientados a aplicaciones de IA en centros de datos. Con estandarización, los fabricantes pueden producir con más confianza y los diseñadores pueden planificar plataformas a varios años.

Además, SOCAMM2 se asocia a velocidades elevadas propias de LPDDR5X, con referencias a 9.600 MT por segundo, un dato importante cuando la prioridad es mover datos rápido y mantener latencia contenida.

Por qué Qualcomm y AMD se fijan en SOCAMM2

Que Qualcomm esté mirando SOCAMM2 encaja con su enfoque en infraestructura de IA, donde el rendimiento por vatio es parte del producto, no un extra. En sistemas de inferencia a escala, la memoria puede decidir si un diseño es viable económicamente: menos consumo permite más capacidad dentro del mismo presupuesto térmico.

En AMD, el interés también tiene lógica por una idea clave: en IA no basta con potencia, hace falta equilibrar ancho de banda, capacidad y coste. SOCAMM2 no sustituye siempre a memorias de altísimo ancho de banda, pero sí puede ser atractiva en configuraciones donde la eficiencia y la escalabilidad de capacidad mandan más que el pico absoluto. Si el formato se estandariza y hay varios proveedores, la barrera de entrada baja.

Micron y Samsung ya enseñan músculo

El ecosistema de memoria ya se está posicionando. Micron anunció módulos SOCAMM2 de gran capacidad, incluyendo 192 GB, destacando mejoras de eficiencia y efectos directos en inferencia como reducciones del tiempo hasta el primer token en ciertos escenarios.

Samsung también ha presentado SOCAMM2 como módulo LPDDR para infraestructura de IA, remarcando ventajas frente a RDIMM DDR5 en ancho de banda y consumo, con cifras que apuntan a mejoras relevantes en eficiencia energética.

Qué cambia en el diseño de servidores y aceleradores

SOCAMM2 empuja a replantear la arquitectura física. Un módulo compacto y de perfil bajo facilita densidad, puede simplificar rutas en placa y, al ser reemplazable, ofrece un ciclo de mantenimiento más propio de centro de datos. Eso abre la puerta a ajustar capacidades según cliente y permitir ampliaciones futuras sin rehacer el sistema completo.

Y hay otro detalle práctico: al usar LPDDR, la gestión térmica y de consumo puede ser más amable en cargas sostenidas, justo donde la IA castiga.

A día de hoy, que Qualcomm y AMD estén explorando SOCAMM2 no equivale a un producto anunciado con fecha cerrada. Falta saber qué familias concretas, qué configuración de módulos y qué volúmenes. Pero el patrón sí está dibujado: estándar por JEDEC, módulos de gran capacidad ya anunciados y una industria obsesionada con el rendimiento por vatio.

También es una señal de madurez del mercado: cuando una pieza se estandariza y varios actores la consideran, aparecen herramientas, validaciones y cadenas de suministro alrededor. Para el cliente final, eso suele traducirse en menos riesgo y más opciones de configuración. Y para los operadores, en una ventaja nada menor: poder reemplazar o ampliar memoria sin tener que retirar todo un nodo por una decisión tomada en fábrica.

Si SOCAMM2 despega, 2026 puede ser el año en que la memoria deje de ser un componente invisible en IA y pase a ser parte central del argumento. Porque el futuro cercano no se decidirá solo por cuántos TOPS caben en una tarjeta. Se decidirá por cuánta IA puedes sostener, durante cuánto tiempo y a qué coste eléctrico.

Fin del Artículo. ¡Cuéntanos algo en los Comentarios!