NVIDIA rompe los límites de la IA con un salto de 10x gracias a los servidores GB200 Blackwell NVL72

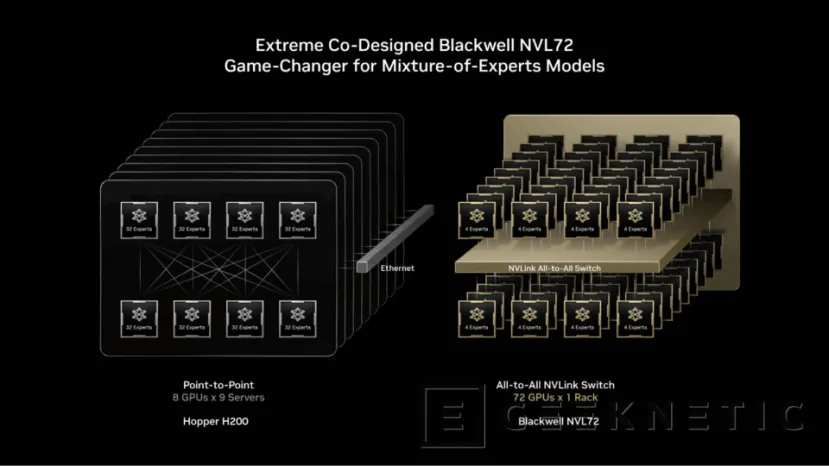

por Manuel NaranjoLa carrera por hacer cada vez más potentes los sistemas de inteligencia artificial ya no va solo de sumar más tarjetas gráficas. NVIDIA acaba de demostrarlo con sus nuevos servidores GB200 Blackwell NVL72, una plataforma capaz de lograr hasta diez veces más rendimiento en modelos Mixture of Experts (MoE) frente a los sistemas de la generación anterior basados en Hopper H200.

El dato se ha medido usando como referencia el modelo Kimi K2 Thinking, uno de los LLM MoE más exigentes del momento, y supone un salto tan grande que muchos lo ven como un punto de inflexión en cómo se va a escalar la IA a partir de ahora.

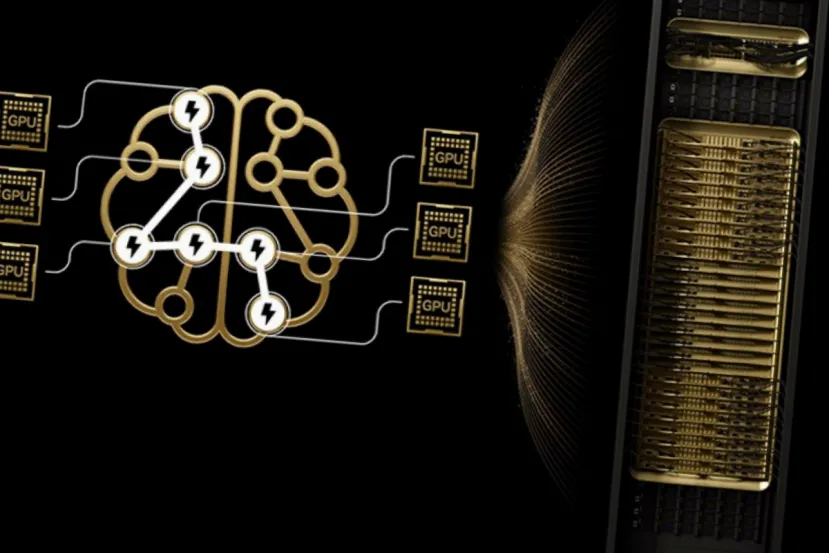

Este incremento no es una simple mejora incremental. Es la consecuencia de cambiar por completo el enfoque: pasar de acumular GPUs individuales a diseñar auténticos “supernodos” donde hardware, red interna y software trabajan como una única máquina gigantesca.

Por qué los modelos MoE son tan difíciles de escalar

Los modelos MoE funcionan de forma muy distinta a los grandes modelos “densos” tradicionales. En lugar de activar todos los parámetros en cada consulta, dividen la red neuronal en distintos “expertos” especializados. Cuando llega un token, solo se activan algunos expertos concretos, lo que permite crear modelos enormes con un coste computacional más contenido.

El problema llega cuando intentas ejecutar esto a gran escala. Cada token debe viajar hasta el experto correspondiente, que puede estar ubicado en otra GPU distinta. Esa necesidad de comunicación constante convierte la interconexión entre chips en un cuello de botella crítico. Aunque tengas GPUs muy potentes, si estas pasan demasiado tiempo esperando datos, el rendimiento real se desploma.

GB200 NVL72: arquitectura pensada para vencer el cuello de botella

Aquí es donde entra en juego el sistema GB200 NVL72. En lugar de ser un simple rack con GPUs sueltas conectadas por red convencional, NVIDIA ha creado un nodo masivo formado por 72 GPUs Blackwell trabajando como una unidad prácticamente única. El sistema integra una interconexión interna de ancho de banda extremo y permite compartir hasta 30 terabytes de memoria, algo crucial para mantener modelos gigantes sin estar moviendo continuamente datos dentro y fuera de cada GPU.

Al testar el modelo Kimi K2 Thinking, que activa unos 32.000 millones de parámetros por inferencia, el resultado ha sido contundente: hasta 10 veces más rendimiento frente a configuraciones equivalentes basadas en Hopper H200. La ganancia no se limita a los tokens por segundo, sino que es todavía más espectacular cuando se mide la eficiencia energética en tokens por megavatio consumido.

Esto quiere decir que no solo se sirve más rápido, sino que se sirve mucho más barato en electricidad, uno de los factores que más preocupa hoy a los operadores de centros de datos de IA.

El papel clave del “co-design” y el software

NVIDIA insiste en que la clave no está únicamente en Blackwell como arquitectura de GPU, sino en su estrategia de co-design, el diseño simultáneo de hardware y software para resolver un problema específico. No se trata de sacar un chip potente y dejar que los desarrolladores se apañen, sino de crear todo el ecosistema de ejecución alrededor de él.

Una de las piezas fundamentales es NVIDIA Dynamo, un sistema de orquestación que gestiona cómo se distribuye el trabajo de inferencia. Dynamo distingue entre dos fases del proceso: la primera es prefill, cuando el modelo procesa el contexto inicial del usuario, y la segunda es decode, cuando empieza la generación de tokens. Cada fase tiene necesidades de paralelismo distintas, y el software las asigna de forma inteligente dentro del clúster para mantener las GPUs siempre ocupadas.

A esto se suma el uso del nuevo formato numérico NVFP4, que reduce la precisión de los cálculos lo justo para mantener la calidad del resultado mientras se disparan la velocidad y la eficiencia energética.

Lo que supone este salto de 10x para la industria

El mensaje implícito del anuncio va mucho más allá de una cifra espectacular para titulares. Lo primero es que confirma que los modelos MoE son la vía principal para escalar la IA en los próximos años. Permiten manejar tamaños colosales de parámetros sin multiplicar de la misma manera el coste de cada consulta, siempre que exista una infraestructura capaz de sostenerlos sin que la red se convierta en un cuello de botella.

En segundo lugar, deja claro que la métrica más relevante ya no es cuántos teraflops promete una GPU, sino cuáles son los tokens por dólar y tokens por megavatio que puede ofrecer un sistema completo. Para las empresas que pagan facturas energéticas astronómicas, la eficiencia es tan importante como la velocidad absoluta.

Este avance presiona directamente a los grandes proveedores de nube. Para poder ofrecer servicios de IA punteros a precios asumibles, necesitarán nodos ultradensos como estos NVL72 o soluciones equivalentes. Quien adopte antes esta arquitectura tendrá margen tanto para reducir costes como para lanzar nuevos productos basados en modelos MoE de gran tamaño.

El futuro inmediato tras Blackwell

Todo apunta a que esta generación marcará la pauta en los próximos años. Veremos aparecer modelos MoE todavía más ambiciosos, diseñados específicamente para aprovechar infraestructuras de este tipo. Al mismo tiempo, NVIDIA seguirá afinando Dynamo y formatos numéricos como NVFP4 para exprimir aún más las posibilidades del hardware.

En definitiva, el salto de 10x conseguido con GB200 NVL72 no es solo una demostración técnica. Es una señal clara de hacia dónde se mueve la industria: menos foco en chips individuales y más en ecosistemas completos capaces de trabajar como un solo cerebro para la IA.

Fin del Artículo. ¡Cuéntanos algo en los Comentarios!