Microsoft presenta Mu, un SLM que se ejecuta localmente en la NPU de los equipos Copilot+ PC

por Edgar OteroMicrosoft ha presentado Mu (se llama así, no es una errata), un modelo de lenguaje pequeño (SLM) que está optimizado para inferir relaciones complejas entre entradas y salidas, garantizando un alto rendimiento y una operación eficiente de forma local. Mu es la tecnología detrás del agente de la aplicación de Configuración en Windows, transformando consultas en lenguaje natural en llamadas a funciones del sistema.

Actualmente, esta funcionalidad está disponible para los Windows Insiders en el Canal Dev, específicamente en PCs con Copilot+. Hay que recordar que estos equipos ahora ya pueden ser ARM o X64. Tal y como menciona Microsoft, Mu se integra completamente en la NPU, alcanzando una velocidad de respuesta superior a los 100 tokens por segundo. Su desarrollo se beneficia de la experiencia adquirida por la compañía al optimizar Phi Silica para NPU, lo que proporcionó información crucial para el diseño de modelos más eficientes para tareas de baja complejidad.

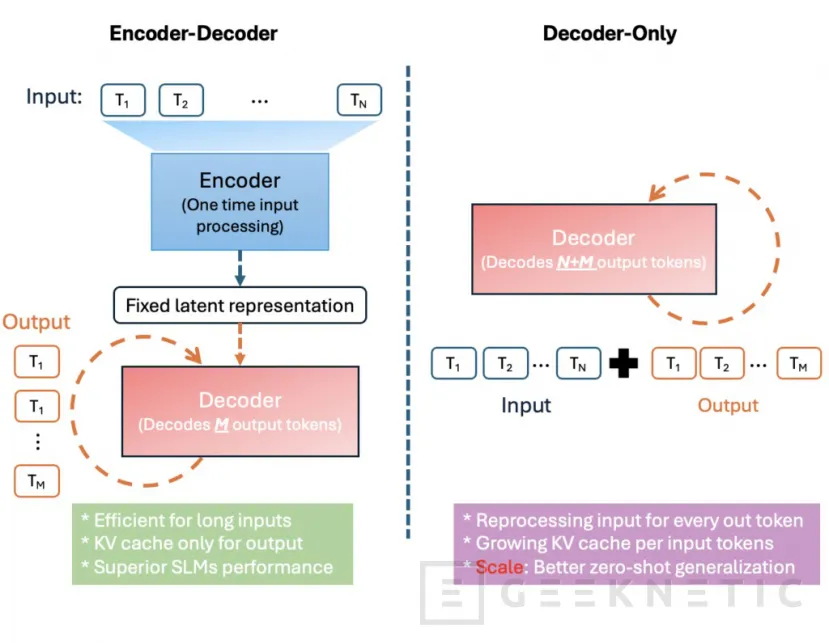

Con 330 millones de parámetros, Mu es un modelo de codificador-decodificador diseñado para implementaciones a pequeña escala y ejecución local. Su arquitectura de transformador procesa la entrada a través de un codificador que la convierte en una representación latente, y luego un decodificador genera los tokens de salida. Este diseño minimiza la sobrecarga computacional y de memoria. Según los datos oficiales, en NPU como la Qualcomm Hexagon, el enfoque de codificador-decodificador de Mu logró una latencia del primer token aproximadamente un 47% menor. Además, presenta una velocidad de decodificación 4,7 veces mayor en comparación con modelos similares de solo decodificador.

Para mejorar el rendimiento en un modelo más compacto, Mu introduce tres innovaciones clave: Dual LayerNorm, Rotary Positional Embeddings (RoPE) y Grouped-Query Attention (GQA). El entrenamiento de Mu se llevó a cabo en GPUs A100 con Azure Machine Learning, comenzando con un preentrenamiento intensivo en datos educativos de alta calidad. Posteriormente, se realizó una destilación a partir de los modelos Phi de Microsoft para aumentar la precisión.

Las evaluaciones de precisión de Mu incluyeron el ajuste fino en tareas como SQUAD, CodeXGlue y el agente de Configuración de Windows. A pesar de su tamaño, el modelo ajustado para tareas específicas demostró un rendimiento notable. Para una ejecución eficiente en el dispositivo, se aplicaron técnicas avanzadas de cuantificación de modelos adaptadas específicamente a las NPU de los PCs Copilot+.

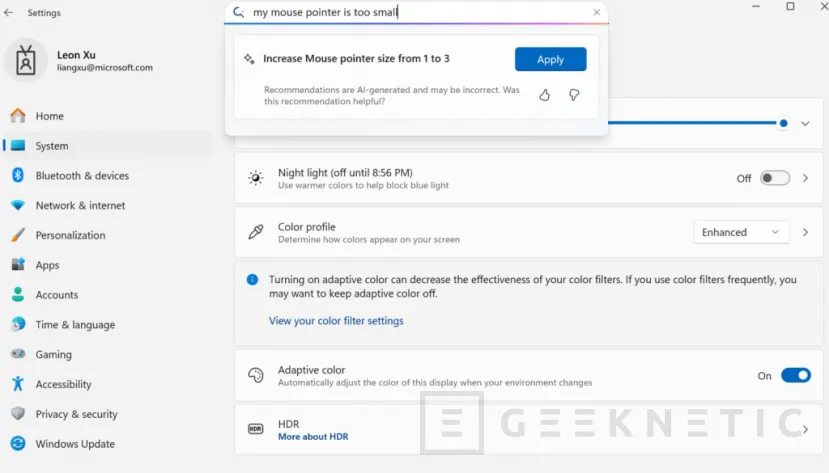

Las aplicaciones de este modelo pueden ser diversas. No obstante, si nos centramos en el agente de Configuración, la idea de Microsoft era crear una IA que comprendiera el lenguaje natural y modificara la configuración de forma inteligente, según la petición del usuario. Como puedes ver en la imagen superior, difundida por la compañía, el usuario le indica a la app de Configuración que su puntero se ve demasiado pequeño. Entonces, el modelo entiende qué es lo que necesita y le ofrece aumentar el tamaño.

Para manejar consultas ambiguas, se integró el agente de Configuración en el cuadro de búsqueda del sistema. Esto permite que las consultas cortas sigan mostrando resultados de búsqueda tradicionales, mientras que las consultas de varias palabras activan el agente para respuestas asociadas a acciones.

Fin del Artículo. ¡Cuéntanos algo en los Comentarios!